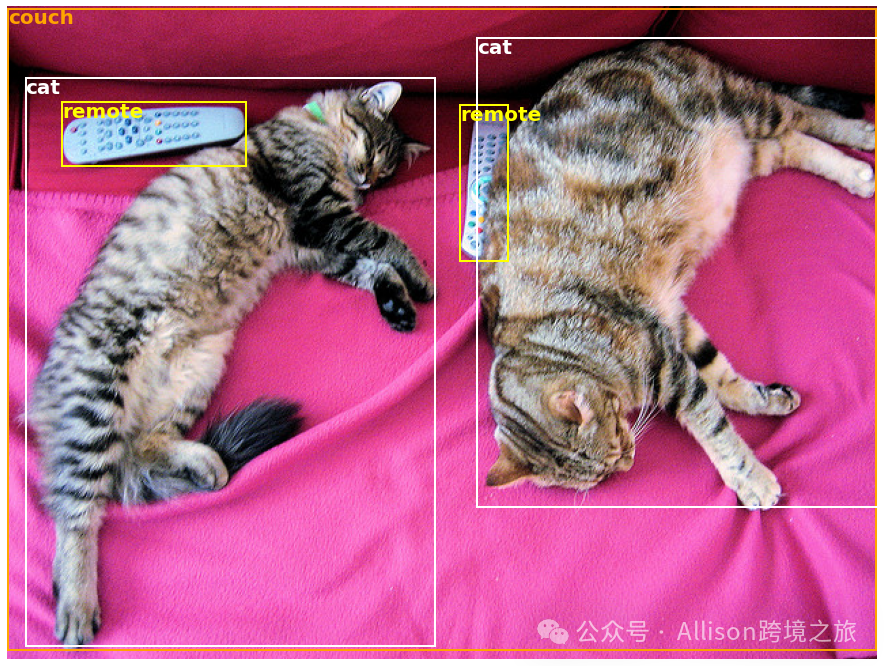

有粉丝留言说想利用AI挖掘开源信息,现在你看到的这类文章就是我利用AI抓取开源信息帮助我生成的文章,是的,我压根看不懂一个代码~如果你对这类AI自动化程序感兴趣,可以看文末加入我的星球有3天试用,我晚点会把资料分享在里面,因为这个和跨境的日常工作不大,我就不录视频了,这个纯属我当初无聊学的,今天本来要录制新视频的,但是还在参加分享会议中,所以明天吧~周末学习不打烊~ 在当今的人工智能领域,各种神经网络模型已经帮助我们解决了许多复杂的问题。但是,如果你能直接访问数千种预训练模型,应用到文本、图像和音频等多种领域,将会有多大的便利呢?今天,让我们一同探索 Hugging Face 提供的开源项目——? Transformers,让最新、最先进的机器学习技术触手可及。 ? Transformers 提供数千种预训练模型,这些模型可以应用于不同的模态(如文本、视觉和音频),执行各种任务: 此外,Transformer 模型还支持 多模态任务,如从扫描文件中提取信息、视频分类和视觉问答等。 为了让用户能够最快速地使用这些强大的预训练模型,? Transformers 提供了便捷的 API。例如,我们可以通过下列代码快速实现情感分析: 该代码会将预训练模型下载并缓存,然后对输入的文本进行评估,返回结果是“积极”的概率。 在自然语言处理(NLP)领域: 在计算机视觉领域: 在音频领域: 此外,在多模态任务中: Hugging Face 提供的平台无疑简化了模型的使用过程,你可以轻松实现从数据预处理、模型训练到推理等全过程。 例如,我们可以轻松实现图像中的目标检测: 运行上述代码后,我们将会得到图片中检测到的目标以及它们的置信度分数和边界框。如下图所示,左边是原始图像,右边是模型的预测结果: 在架构设计上,? Transformers 支持通过三大热门深度学习库——Jax、PyTorch 和 TensorFlow 无缝切换。不论你使用哪种框架进行模型训练,都可以用另一种框架进行推理。这无疑极大地增加了灵活性和效率。 要想快速上手 ? Transformers 提供的预训练模型,只需要几行代码: 对于 PyTorch: 对于 TensorFlow: 在这段代码中,tokenizer 负责对输入文本进行预处理,而 model 则接收处理后的输入进行推理。 您可以通过以下命令安装 Transformers: 或者选择使用 conda: ? Transformers 需要 Python 3.8 以上版本,并且需要至少安装 Flax、PyTorch 或 TensorFlow 其中之一。 Hugging Face 开发的 ? Transformers 项目为机器学习和深度学习领域带来了便捷和高效。无论你是研究人员、开发人员,还是学生,都能够利用这个工具箱轻松实现各种复杂任务。同时,丰富的预训练模型库为不同应用场景提供了强大的支持。 如果你正寻找一个可靠、易用并且功能强大的工具来加速你的机器学习项目,不妨尝试一下 ? Transformers,相信你会有惊喜的发现。 希望这篇介绍能帮助你更好地了解 ? Transformers 的强大功能并开始你的机器学习之旅!

项目简介

在文本任务中的应用

在图像任务中的应用

在音频任务中的应用

快速上手

from transformers import pipeline

# 为情感分析准备一个流水线

classifier = pipeline('sentiment-analysis')

# 对输入文本进行情感分析

classifier('We are very happy to introduce pipeline to the transformers repository.')

应用示例

更详细的示例

import requests

from PIL import Image

from transformers import pipeline

# 下载包含可爱猫咪的图片

url = "https://huggingface.co/datasets/huggingface/documentation-images/resolve/main/coco_sample.png"

image_data = requests.get(url, stream=True).raw

image = Image.open(image_data)

# 为目标检测准备一个流水线

object_detector = pipeline('object-detection')

object_detector(image)

项目架构

from transformers import AutoTokenizer, AutoModel

tokenizer = AutoTokenizer.from_pretrained("google-bert/bert-base-uncased")

model = AutoModel.from_pretrained("google-bert/bert-base-uncased")

inputs = tokenizer("Hello world!", return_tensors="pt")

outputs = model(**inputs)from transformers import AutoTokenizer, TFAutoModel

tokenizer = AutoTokenizer.from_pretrained("google-bert/bert-base-uncased")

model = TFAutoModel.from_pretrained("google-bert/bert-base-uncased")

inputs = tokenizer("Hello world!", return_tensors="tf")

outputs = model(**inputs)

安装指南

使用 pip 安装

pip install transformers

使用 conda 安装

conda install conda-forge::transformers

环境要求

总结

文章为作者独立观点,不代表DLZ123立场。如有侵权,请联系我们。( 版权为作者所有,如需转载,请联系作者 )

网站运营至今,离不开小伙伴们的支持。 为了给小伙伴们提供一个互相交流的平台和资源的对接,特地开通了独立站交流群。

群里有不少运营大神,不时会分享一些运营技巧,更有一些资源收藏爱好者不时分享一些优质的学习资料。

现在可以扫码进群,备注【加群】。 ( 群完全免费,不广告不卖课!)

发表评论 取消回复