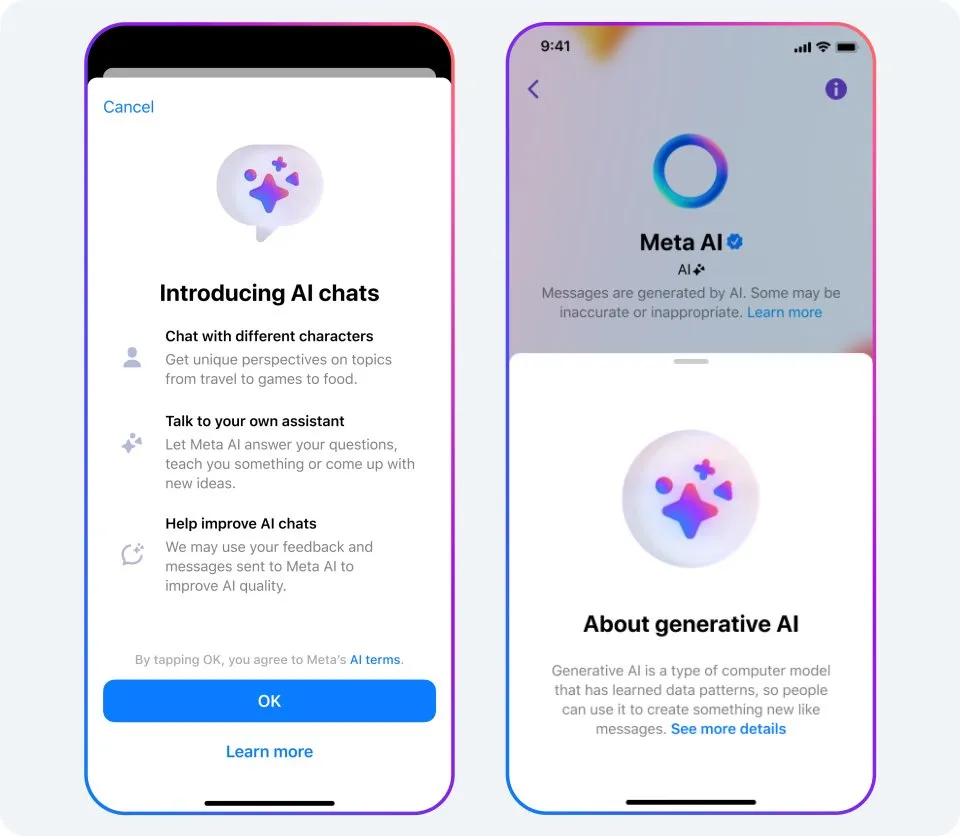

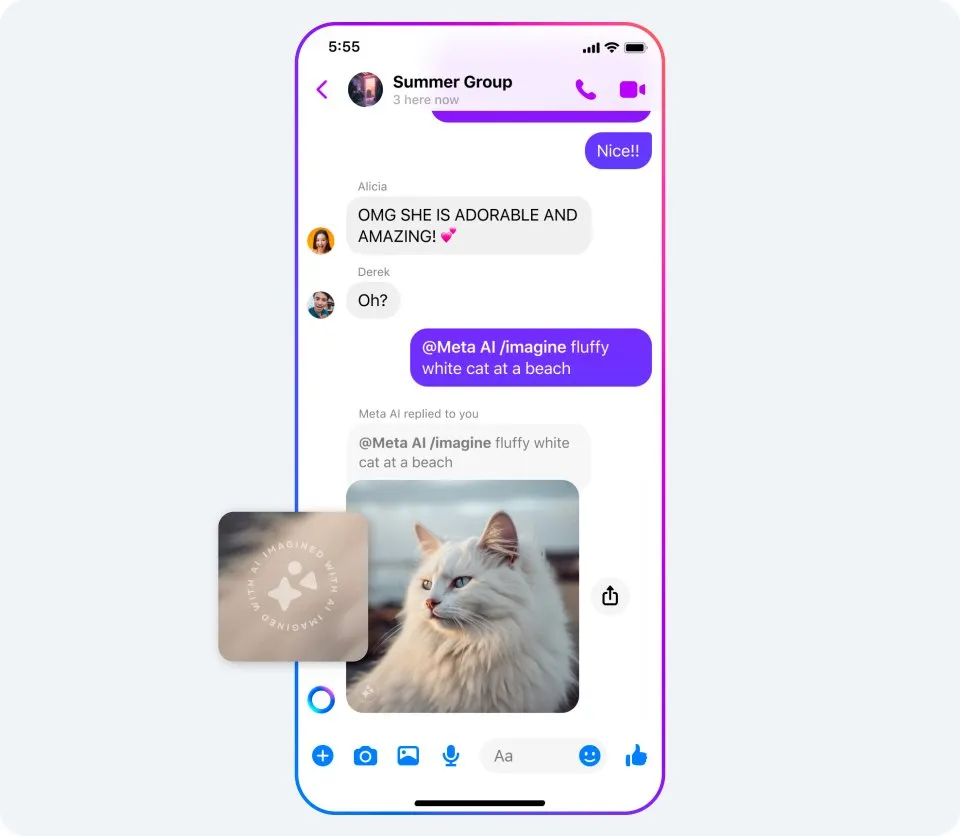

● ● ● 要点 我们将在正式发布 AI 功能和模型之前为之构建安全措施,以便用户获得更加安全愉悦的使用体验。 与所有生成式 AI 系统一样,这些模型可能返回不准确或不恰当的输出结果。随着这些功能逐步完善以及更多用户分享反馈,我们将持续专注于功能改进。 我们正积极与全球政府机构、其他公司、学术界和民间团体的 AI 专家、家长、隐私专家和倡导者等各方合作,共同建立负责任的监管框架。 十多年来,Meta 一直是人工智能领域的开拓者。我们已面向研究人员发布了 1,000 多个 AI 模型、库和数据集,其中包括与 Microsoft 合作推出的最新版大型语言模型 Llama 2。 在 Connect 2023 大会上,我们宣布了几项全新生成式 AI 功能,用户可借其在我们的平台上获得更具社交性和沉浸感的体验。我们希望此类生成式 AI 工具能够为用户提供各种形式的支持。想象一下一群好友共同策划旅行:他们可以在群聊中向 AI 助手询问活动和餐厅推荐。再比如,教师可以利用 AI 助手来针对不同学生的学习风格制定个性化课程计划。 开发这项技术意味着我们有责任制定最佳实践和相关政策。尽管生成式 AI 有许多激动人心和富有创意的用例,但它并非总是完美无憾。例如,底层模型有可能生成虚构的答案,或者放大其从训练数据中学习到的刻板观念。我们将过去十年累积的经验融入到新功能中,比如推出提醒功能,让用户了解生成式 AI 的局限性;以及公正性分类技术,以帮助我们发现和移除有风险的回复。这些功能的开发皆遵循了 Llama 2 负责任使用指南中概述的行业最佳实践。 秉持负责任开发人工智能的原则,我们还对产品运行压力测试以提高安全性能,并定期与国际政策制定者、学术界和民间团体的专家以及其他业内同僚开展合作,共同推动这项技术的负责任使用。我们将逐步发布这些功能,并推出 Beta 测试版 AI 功能。我们将持续改进这些功能,根据技术发展和用户的日常使用情况进行迭代优化。 我们如何负责任地开发并将用户安全放在首位? 我们开发的新型文本交互体验(比如基于大型语言模型的 Meta AI 助手)由自定义 AI 模型提供支持,而这些模型是在 Llama 2 模型的基础上构建的,并充分利用了 Llama 2 模型在安全性和可靠性方面的训练成果。我们针对今天宣布的功能也开发了特定保护措施。 您可进一步详细了解我们为识别潜在漏洞、降低风险、增强安全性和提升可靠性所采取的措施。例如: 通过红队 (Red Teaming) 演练携手内外部专家评估和改进我们的对话式人工智能。权威专家团队耗费数千小时对这些模型进行压力测试,检测可能出现的意外使用方式以及识别和修复漏洞。 对模型进行微调优化。这包括训练模型执行特定任务,例如生成优质图像,并使用指令来增加其提供有帮助回应的可能性。我们还训练模型,使其能够针对安全问题提供得到专家支持的资源。例如,AI 会在回复某些医疗相关询问时,推荐当地的心理健康和饮食失调援助组织,同时明确表示无法提供专业医疗建议。 针对安全和负责任准则训练模型。通过对模型进行合规性训练,我们可以减少其在我们的应用中分享可能对所有年龄段有害或不妥当的回应的可能性。 采取措施降低偏差。解决生成式 AI 系统的潜在偏差是一大新课题。与其他 AI 模型一样,鼓励更多用户使用这些功能并分享反馈意见可以帮助我们改进方法。 开发新技术来检测政策违规内容并对其采取措施。我们的团队构建了算法,可实现在将有害回应分享给用户之前对其进行扫描和过滤。 在 AI 功能中内置反馈工具。任何 AI 模型都并非完美无憾。我们将利用接收的反馈持续训练模型,以提高安全性能及自动检测政策违规行为。我们还通过 Meta 长期运行的漏洞悬赏计划向安全研究人员提供我们新开发的生成式 AI 功能。 我们如何保护用户的隐私? 我们受到国际监管机构、政策制定者和专家的监督,负有保护用户隐私的责任。我们与之合作以确保我们开发的内容遵循最佳实践,并达到数据保护的严格标准。 我们认为让用户了解用来训练生成式 AI 产品所依托模型的数据类型非常重要。 我们如何确保用户了解新功能的使用方法以及功能局限性? 我们会在功能内提供信息说明,帮助用户了解何时在与 AI 交互以及这项新技术的运作原理。我们会在产品体验中指出,系统可能返回不准确或不恰当的输出结果。 过去一年中,我们发布了 22 个“系统信息卡”,为用户提供简单易懂的信息,帮助其了解 AI 系统如何做出影响他们的决策。 如今,我们将在 Meta 的 AI 网站上推出新的生成式 AI 系统信息卡——其中包括为 Meta AI 提供文本生成支持的 AI 系统信息卡,以及为 AI 贴图、Meta AI、加料和背景工具生成图像的 AI 系统信息卡。这其中包含交互演示,以便用户了解调整输入提示对模型输出结果的影响。 我们如何帮助用户判断出图像是由 AI 功能创建的? 我们的产品开发遵循行业最佳实践,旨在防止用户利用我们的工具传播错误信息。通过 Meta AI、加料和背景工具创建或编辑的图像将具有可见标记,以便用户辨别出此类内容由 AI 生成。此外,我们还努力开发其他技术以在 Meta AI 生成的图像文件中嵌入信息,并计划随着技术改进将其应用到其他体验中。我们不计划为 AI 贴图添加这些功能,因为它们没有那么逼真,因而不太可能被误认作真实图像。 目前,针对如何标识和标注 AI 生成式内容,业界尚未建立任何统一标准。我们相信此举意义重大,因而通过参与类似 Partnership on AI 的论坛与其他公司开展合作,希望共同制定这些标准。 我们采取哪些措施来阻止用户使用生成式 AI 传播错误信息? AI 在我们处理错误信息和其他有害内容方面起到了关键作用。例如,我们开发了 AI 技术,用于匹配与之前的事实核查内容近乎重复的内容。我们还设计了一款名为 Few-Shot Learner 的工具,这款工具灵活性更强,可快速针对新出现或不断变化的有害内容类型采取操作,并且支持 100 多种语言的使用场景。以前,我们需要收集数千甚至数百万个示例以建立足够庞大的数据集来训练 AI 模型,然后加以改进微调以使其正常运行,而 Few-Shot Learner 可以仅基于少数示例来训练 AI 模型。 与现有 AI 工具相比,生成式 AI 可以帮助我们更加快速准确地移除有害内容。我们已开始测试大型语言模型 (LLM),针对社群守则对模型进行训练,使其帮助确定某条内容是否违反我们的政策。这些初步测试表明,大型语言模型 (LLM) 在性能上优于现有的机器学习模型,或者至少可对 Few-Shot Learner 这类模型起到增强作用,因此我们相信,生成式 AI 未来能够帮助我们更好地执行政策。 长按扫码参加 【Meta 海外营销秘笈 】小程序 免费课程 出海洞察,营销工具,独家活动 从电商、应用到游戏行业, 优质内容,一网打尽!

文章为作者独立观点,不代表DLZ123立场。如有侵权,请联系我们。( 版权为作者所有,如需转载,请联系作者 )

网站运营至今,离不开小伙伴们的支持。 为了给小伙伴们提供一个互相交流的平台和资源的对接,特地开通了独立站交流群。

群里有不少运营大神,不时会分享一些运营技巧,更有一些资源收藏爱好者不时分享一些优质的学习资料。

现在可以扫码进群,备注【加群】。 ( 群完全免费,不广告不卖课!)

发表评论 取消回复