应该是前年,我分享过使用老域名来做网站的事情。当时还专门录了一个视频来讲述怎么找老域名,以及买老域名的一些注意事项。

但是 24 年谷歌算法已经做了针对老域名滥用的专门更新,所以现在若还是期待着使用老域名能实现网站快速冷启动的话,可能最终的结果就有点让人失望了。

今天早上在群里分享了自己的两个实操案例,同样的产品且大体含义差不多的关键词。上个月特意买了一个有外链历史的老域名,特地去搭建了一个站点做这块的实验。

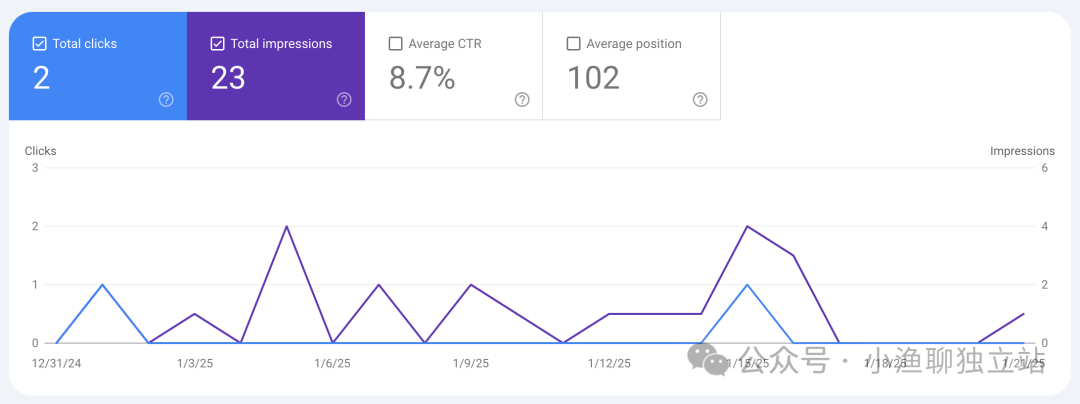

上图便是 GSC 的一些表现数据,不仅曝光几乎没有,且初始的网站排名特别特别低。另外就是关键词出词,过去了快一个月的时间,一个出词信息都没有。

相反,上周末使用了一个全新的域名,再去尝试上这款产品的站点。

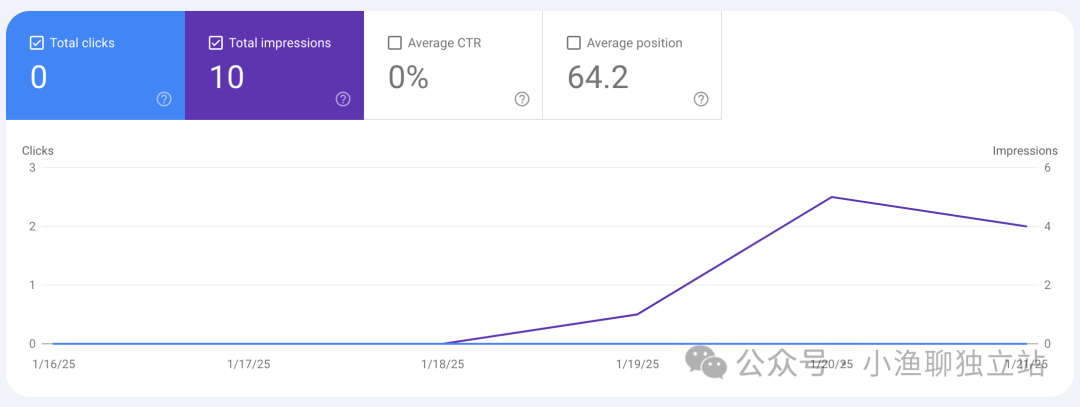

仅仅过去了几天,可以从 GSC 数据里看到的便是相应的曝光量正常,初始排名要比第一版高很多。还有便是关键词出词信息也都很正常(比如截止今天这个新站点便有了 9 个出词信息)。

我现在回想,这两个站点唯一的区别真的就只有域名了(一个是有外链历史的老域名,一个是没有任何历史记录的新域名),其他的点基本都是相同的(网站布局一样,内容框架一样,且内容都是 AI 写的)。

所以我便初步得出了一个结论,尽可能不要用老域名,尤其是不要买有外链历史的老域名去建站。

当然在群里沟通的时候,也有其他小伙伴分享了这块的实操经历,与我的结论不谋而合。

既然已经「知其然」,那下一步便是「知其所以然」,也就是尽可能搞清楚底层的算法逻辑是什么。

于是有朋友推荐我看这篇文章。

链接:https://searchengineland.com/unpacking-googles-massive-search-documentation-leak-442716

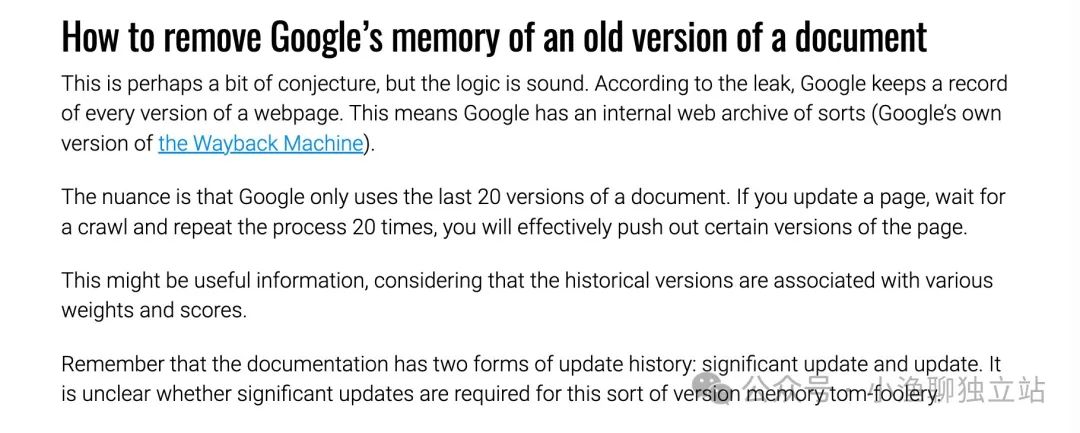

这篇文章主要是解析最近这次谷歌算法泄漏出来的文档信息,其中有一块便提到了谷歌会保存网页的历史快照信息。

那一个可能的逻辑,就是在判断网站是不是老域名滥用时,算法会去从其「网页快照数据库」中查询该域名的历史。一旦有相应的记录匹配,便会给该网站更长的考验期。

像上图中也提及了,算法会去取最近 20 次的网页快照。那如果想消除这块的影响,一个可行的办法就是多更新内容,然后让爬虫爬虫爬取并索引。

等最近 20 次的快照信息,都是我们自己的内容时,相应的的考察可能会放松点吧。

一点经验分享,仅供参考。

文章为作者独立观点,不代表DLZ123立场。如有侵权,请联系我们。( 版权为作者所有,如需转载,请联系作者 )

网站运营至今,离不开小伙伴们的支持。 为了给小伙伴们提供一个互相交流的平台和资源的对接,特地开通了独立站交流群。

群里有不少运营大神,不时会分享一些运营技巧,更有一些资源收藏爱好者不时分享一些优质的学习资料。

现在可以扫码进群,备注【加群】。 ( 群完全免费,不广告不卖课!)

发表评论 取消回复