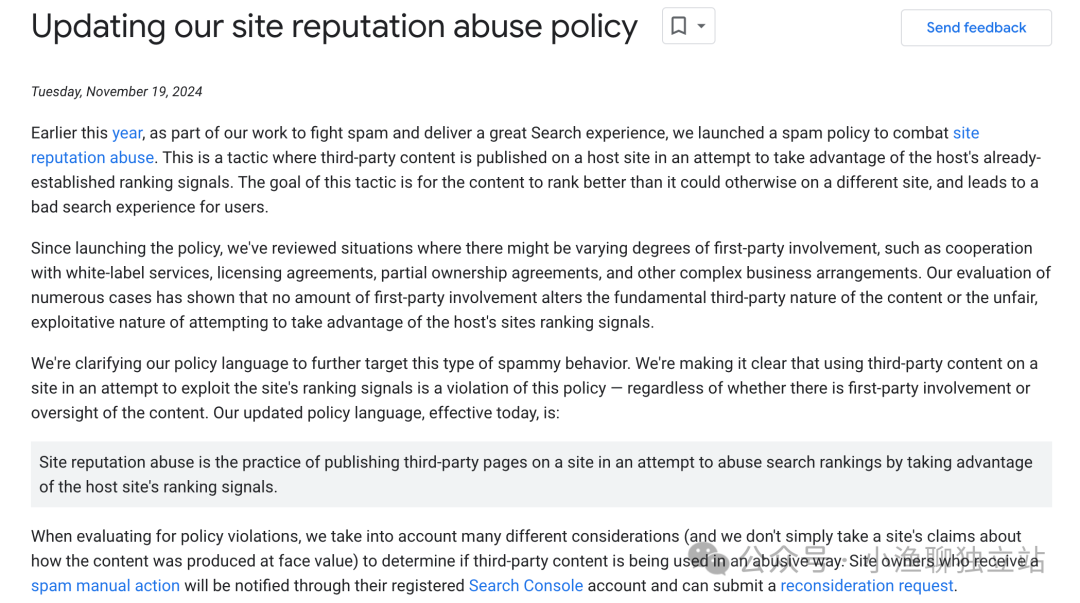

谷歌搜索中心在 11 月更新了一篇文章,Updating our site reputation abuse policy,那今天简单聊聊这篇文章背后所映射出来的问题。

认真读一下这篇文章,好像文章什么东西都讲到了,但是又好像不知道讲的是什么。其实文章中提及的“Site Reputation Abuse”,主要针对的也就是寄生虫 SEO 这种模式。

何谓「寄生虫 SEO」,说白了就是利用别的高权重网站,来发表我们的自己的内容,然后获取相应的排名。由于平台网站的权重非常大,那只要我们的内容上传上去后,便会很快被搜索引擎抓取并索引,后续就是出词与排名了。

虽然我们的内容在平台网站上,但是通过内容获取到的流量则是我们的。那后续我们可以想办法再将这些流量,引导到我们自己的网站上,或者联盟平台的落地页上去变现。

其实这样的平台有非常多,像 Medium,LinkedIn,SlideShare,等等等。基本上只要平台支持 UGC 模式,那这样的平台理论上都可以作为我们「寄生」的目标。

所以谷歌更新这篇文章的目的在哪里呢,是要禁止这种模式,还是说要引导这种行为。

如果单纯是打算引导用户行为,那基本就属于是全篇废话了。而要禁止这种模式,其难度又非常巨大。

因为平台网站不像我们这些小卡拉米的小网站,主要原因有这么几点。

其一是平台网站的更新内容量巨大,类似 Medium,Reddit 这样的平台,每分钟的内容更新量都以「万」为计量单位的(可能还少说了)。

如果所有的内容都去仔细检查一点,那对算力的要求就会非常非常高,搜索引擎真的承担不起这样的成本。

其二是如果直接对大平台的内容直接放行,那其中一些低质量的内容又会有损搜索质量。

尤其是当一些低质量的内容,仅仅只是因为平台权重的缘故,而在搜索结果页上排在优秀且更具备行业专家资质的内容前面的话,那对用户体验而言无疑是有损的。

所以给我的感觉就是,谷歌搜索现在真的挺为难的,且暂时没有什么好的办法去处理这种情况。像文章中提及的类似「白名单」、「合作平台」等等预防方式,在我看来基本都没什么用。

甚至我看到外网有些讨论说什么,在算法中引入平台的一些文章评价指标来评估内容质量,像阅读量、点击量、分享情况,等等。但是这些数据都是非常容易刷上去的啊,几美金的成本便能制作出一篇看似很爆的文章。

所以大家如果有兴趣的话,不妨尝试着将自己的内容分享到这些内容平台上去做做这种 SEO 模式。至少从我们自己的数据反馈来看,这种方法肯定是有用的。不仅可以获取对应站点的内部流量,还能获取搜索流量,一举两得。

文章为作者独立观点,不代表DLZ123立场。如有侵权,请联系我们。( 版权为作者所有,如需转载,请联系作者 )

网站运营至今,离不开小伙伴们的支持。 为了给小伙伴们提供一个互相交流的平台和资源的对接,特地开通了独立站交流群。

群里有不少运营大神,不时会分享一些运营技巧,更有一些资源收藏爱好者不时分享一些优质的学习资料。

现在可以扫码进群,备注【加群】。 ( 群完全免费,不广告不卖课!)

发表评论 取消回复