我平时会经常浏览一些关于 SEO、数字营销的最新的消息,像 Search Engine Land 这样的平台,基本每天会花不少时间在上面。

但是在每天浏览信息的过程中,我发现有一个点特别让我不爽,那就是这个平台上的大多数文章,其实内容含金量并不高。所以花大量时间去专门浏览这类信息,就有点浪费时间了。

所以一个比较好的做法,就是希望有一个专门的服务应用,能将这个平台上的每一条信息总结成短讯,然后每天定时发送给我。

对于那些含金量不高的消息,直接看看短讯就可以略过去了。而对于含金量不错,或者我比较感兴趣的文章,再专门点击进去,针对性去消化其中的内容。

其实对于这个点,我一直有在调研有没有相关的应用能满足我的需求。无奈搜寻了好几圈,依旧没有发现比较合适的应用。

然后最近这段时间,干脆自己花了点精力去开发了一个。这里有两种思路,我简单分享一下。

方案一是利用现成的工具,去做一款专门的应用,但是这种方案的自动化水平要低一些。

比如最简单的某书多为表格,现在已经将 DeepSeek AI 能力嵌入进去了,那我现在需要做的就是将每天最新文章的链接整理下来,放在多维表格,然后再让 AI 去帮我总结整理咨询便可以了。

但是根据我自己的测试,如果只是单纯放文章链接的话,受限于 AI 的算力与相应的一些抓取限制,这块的效果并不是很好。

所以最佳的一个做法,还是将文章内容下载下来,然后整理到多维表格中去,然后再让 AI 进行总结。

其实这种方案贵在简单,基本人人能都上手设计属于自己的信息消化工作流。

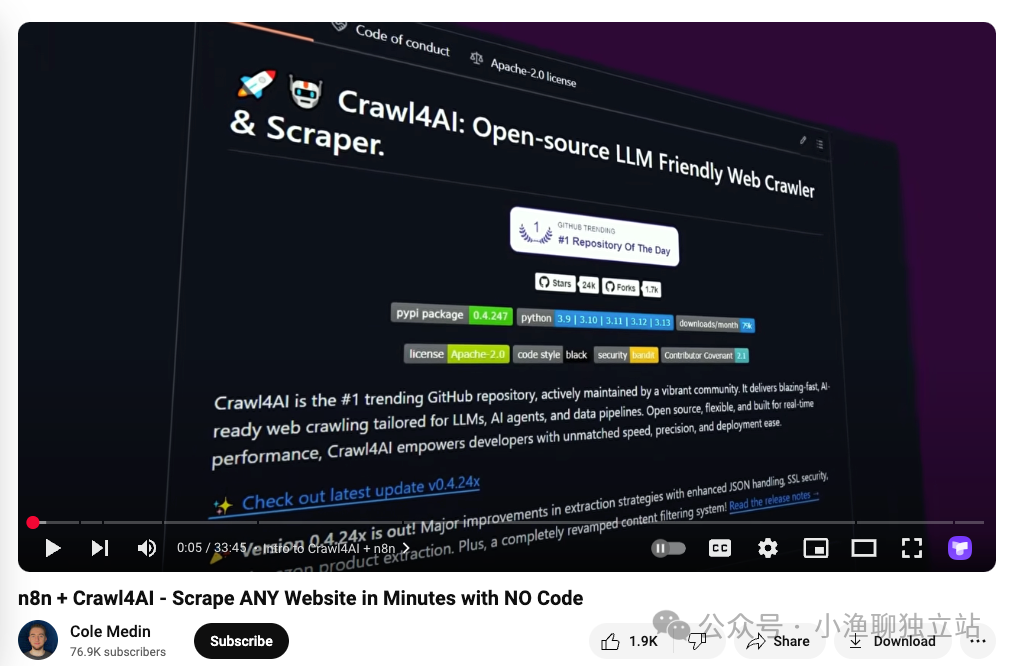

但是如果想让这个流程的自动化程度更高一些,可能就需要使用某些更复杂的技术栈了。比如上图中提及的这种方案,使用 N8N 做自动化流程的管理,并使用 CrawlAI 开发相应的信息抓取爬虫。

然后两种技术栈联动,实现我们想要的自动化功能,并在过程中实现最大程度的自动化管理。其实原理不难,整个流程的执行过程也很清晰,就是将「方法一」的整个流程进行高度自动化而已。

所以有兴趣的朋友,或者有相关需求的朋友,不妨动手实操一下。

另外,其实这种 AI 总结的文案内容,还可以对其进行加工一番,做成自己网站上的内容。

比如将总结的文字内容,使用相应的技术手段生成语音内容,便可以上传到播客平台上做成特定的信息流。不过这里需要注意版权的问题,需要特别研究一下这块的使用协议。

如果只是单纯做文案信息的话,也可以考虑将上一步总结的内容做成「策展内容」,然后集成到自己的网站上去丰富自己的网站内容。

那有兴趣的朋友可以尝试着去调研一下与之相关的平台,然后设计专属于自己的工作流便可以了。

文章为作者独立观点,不代表DLZ123立场。如有侵权,请联系我们。( 版权为作者所有,如需转载,请联系作者 )

网站运营至今,离不开小伙伴们的支持。 为了给小伙伴们提供一个互相交流的平台和资源的对接,特地开通了独立站交流群。

群里有不少运营大神,不时会分享一些运营技巧,更有一些资源收藏爱好者不时分享一些优质的学习资料。

现在可以扫码进群,备注【加群】。 ( 群完全免费,不广告不卖课!)

发表评论 取消回复